Инструкция по настройке дисциплины обработки трафика TBF (Token Bucket Filter) на виртуальных серверах под управлением операционных систем семейства Linux.

Что это такое?

Для управления трафиком можно использовать не только сетевое оборудование, но и возможности ядра Linux. Основным механизмом управления трафиком является применение дисциплин обслуживания, например: бесклассовые - fifo, fifo_fast, TBF, классовые - HTB, CBQ, PRIO.

Что такое TBF?

Token Bucket Filter - это бесклассовая дисциплина обслуживания, доступная для управления трафиком с помощью команды tc. Дисциплина tbf пропускает только пакеты, которые не превышают некоторую установленную скорость, но с возможностью разрешить короткие всплески, превышающие эту скорость.

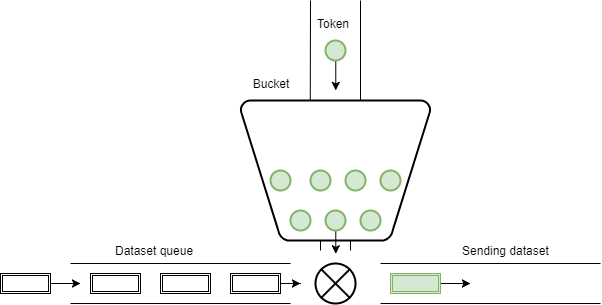

Реализация TBF состоит из буфера (bucket), постоянно заполненного некоторыми виртуальными фрагментами информации, называемыми токенами, с определенной скоростью (rate). Самым важным параметром буфера является его размер, то есть количество токенов, которые он может хранить. Также есть очередь поступающих данных.

Каждый прибывающий токен берет один входящий пакет данных из очереди данных и затем удаляется из ведра. Этот алгоритм дает три возможных сценария:

- Данные поступают в очередь со скоростью, равной скорости входящих токенов. В этом случае каждый входящий пакет имеет свой токен и передача данных происходит без задержки.

- Данные поступают в очередь со скоростью, меньшей, чем скорость токенов. Каждый входящий пакет имеет свой токен, но при этом они накапливаются, вплоть до размера ведра. Затем эти токены могут использоваться для отправки данных со скоростью, превышающей стандартную скорость токена, в случае возникновения коротких пакетов данных.

- Данные поступают в очередь со скоростью, большей, чем скорость токенов. Для поступающих пакетов данных не будет хватать токенов, что приведет к задержке отправления на некоторое время. Это называется «чрезмерной ситуацией». Если доступный объем очереди будет заполнен, поступающие пакеты будут отбрасываться.

Настройка TBF

Настройка дисциплины tbf выполняется с помощью утилиты tc, в общем виде команда выглядит так:

tc qdisc add dev <интерфейс> root tbf rate <скорость> latency <время> burst <размер ведра>

| Параметр | Значение |

| qdisc | дисциплина обслуживания для интерфейса |

| latency | максимальное время, которое может провести поступивший пакет данных в очереди |

| burst | размер ведра в байтах |

| rate | уровень скорости поступления токенов |

Пример:

tc qdisc add dev ens160 root tbf rate 2mbit latency 50ms burst 1540

Проверка настроек TBF

Для начала на сервере настроим Firewall:

iptables -A INPUT -p tcp --dport 8000 -j ACCEPT

iptables -A INPUT -p tcp --sport 8000 -j ACCEPT

iptables-save

Проверить настройки шейпера tbf можно с помощью утилиты iperf3. Скачать ее на Windows можно с официального сайта. Она будет доступна для работы в командной строке cmd. Для установки на Linux выполните следующие команды:

sudo apt-get install iperf3

Также установку необходимо произвести на сервере.

На сервере выполните команду, которая будет прослушивать порт 8000:

sudo iperf3 -s -p 8000

На клиенте выполним команду генерации исходящего трафика:

iperf3 -c <ip-адрес> -p 8000 -i 5 -R

Примечание: при использовании ключа -R сервер работает в режиме reverse, в этом случае сервер генерирует пакеты, а клиент получает, таким образом мы можем проверить ширину канала на сервере.