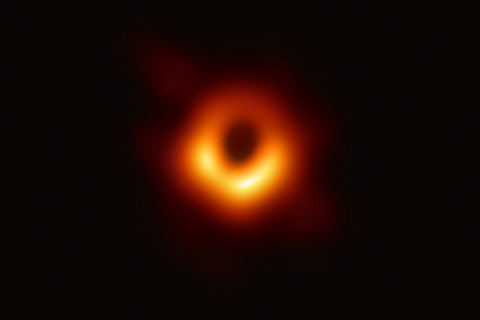

Ученым удалось получить первое в истории изображение черной дыры галактики M87 с использованием сети Телескопов Горизонта Событий. Это событие стало историческим и доказавшим, что существовавшие ранее научные концепции в этом аспекте подтверждаются на практике.

По этому поводу в Сети уже достаточно информации, но нас заинтересовали именно детали, касающиеся преобразования аналоговых данных в цифровые, их последующей передачи и обработки. На наш взгляд, данное открытие хорошо иллюстрирует потенциал, который предоставляют науке современные сетевые и облачные технологии. Само собой, мы в компании 1cloud, являющейся облачным провайдером, не могли не заинтересоваться этой темой.

В этой статье не будет подробного описания архитектуры самих радиотелескопов, но мы постараемся разобраться, как элементы инфраструктуры EHT связаны между собой и как проводилась последующая обработка полученных при наблюдениях данных.

Детали исследования

Прежде всего стоит отметить, что EHT (Event Horizon Telescope, Телескоп Горизонта Событий) - это не один элемент инфраструктуры, а сеть планетарного масштаба, соединяющая и синхронизирующая восемь разрозненных радиотелескопов, в результате чего появляется новая сущность – единый виртуальный радиотелескоп размером с земной шар. Именно такая концепция позволила зафиксировать и проанализировать объект, расположенный в 55 млн. световых лет от Земли.

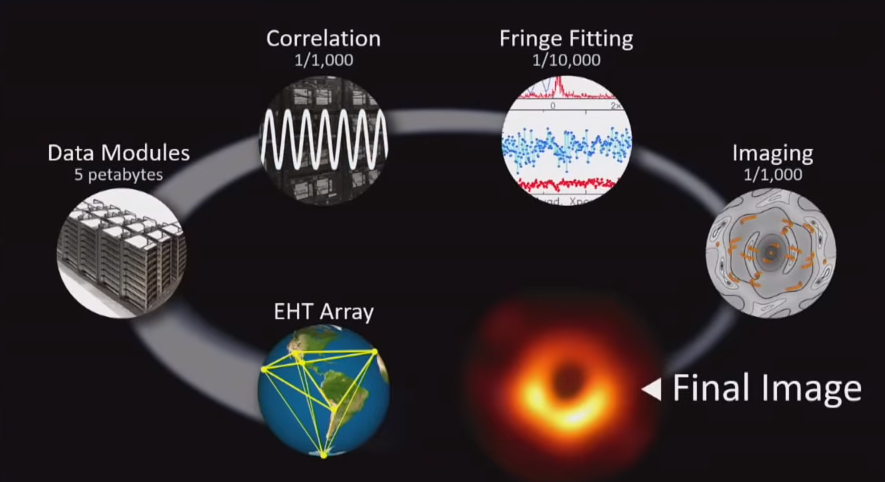

Еще один важный аспект – схема получения изображения. Стоит отметить, что сами по себе радиотелескопы не производят как таковой фотографии. Они работают с интерференциями волн. Полученное же изображение черной дыры – результат колоссальной работы по анализу данных, полученных с сети телескопов, их очисти и построения изображения с использованием не менее 4 различных методов. В результате полученные от разных групп исследователей изображения сравниваются и усредняются для получения финального изображения.

Соответственно, говоря о полученном снимке, мы говорим не только о прогрессе радиооптических, но и сетевых/облачных технологий, позволяющих обеспечить достаточно быстрые передачу и анализ данных, автоматизировать их очистку от артефактов и ненужной информации и построить изображение.

Начнем с цифр. За время наблюдений сетью телескопов было сгенерировано более 5 петабайт данных, каждый фрагмент которых был привязан к точному времени их получения благодаря синхронизации элементов глобальной инфраструктуры с помощью высокоточных атомных часов. Изначально данные записывались локально на каждый массив, расположенный в непосредственной близости от самих радиотелескопов/ресиверов. В общей сложности таких дисков было более 500, а объем данных, хранящихся на них, оказался слишком велик для передачи по сети за приемлемое время, поэтому на последующую обработку (в немецкую команду и Массачусетский Технологический Институт) жесткие диски отправлялись традиционной авиаперевозкой.

В результате последующих манипуляций по корреляции и таймингу полученной информации, ее очистке от «шума», полученного вследствие специфики работы радиотелескопов и атмосферных условий, объем данных для анализа удалось сократить до более привычных терабайт. За эту часть работы отвечало облако на базе суперкомпьютеров института Max Planck и обсерватории Массачусетского Технологического Института.

На следующем этапе был проведен так называемый fringe fitting – процедура окончательной калибровки данных, разнящихся ввиду различия фаз, частот и задержек различных элементов инфраструктуры EHT.

Теперь можно было приступить непосредственно к построению изображения на основе полученных данных. Построение выполнялось параллельно независимыми командами ученых с использованием нескольких алгоритмов. Кстати, один из таких алгоритмов (Sparse Modelling) был реализован на Python-библиотеке Sparselab, выпущенной под open-source лицензией GNU GPL v3, как и использовавшийся для управления данными полученными от VLBI модуль “ethim”.

При сравнении полученных вариантов изображения выяснилось, что большинство из них практически идентичны. Путем их усреднения был получен окончательный вариант снимка.

Инфраструктура

Ключевая технология, скрывающаяся за наблюдениями с использованием EHT – это система VLBI (Very-long-baseline Interferometry), обслуживающая сеть радиотелескопов для создания из них единой виртуальной сущности. Разработка таких систем ведется давно, но еще несколько лет назад суммарная частота записи не превышала 4Gbps. На текущий же момент система VLBI может показывать куда более высокие результаты в 64Gpbs, что и позволяет реализовать столь амбициозный проект. В достижении этого показателя важнейшую роль сыграли протоколы передачи данных, скоростные SSD-накопители, высокопроизводительные (10Gbps) сети и программируемые логические интегральные схемы (FPGA). Говоря о накопителях, стоит принимать во внимание то, что жесткие диски, на которых выполнялась запись первичных данных, были установлены локально на телескопах – участниках сети EHT, расположенных на высотах до 5000 метров. По этой причине диски должны быть «подготовлены» для работы в таких условиях. В данном случае использовались заполненные гелием герметичные накопители. Кстати, со слов участников проекта, ни один диск не дал сбоя за весь период исследований, хотя общий объем собранных данных превысил 10 000 часов параллельной записи на 128 жестких дисков с совокупным эффективным объемом хранилища 1PB (2PB с учетом резервирования данных).

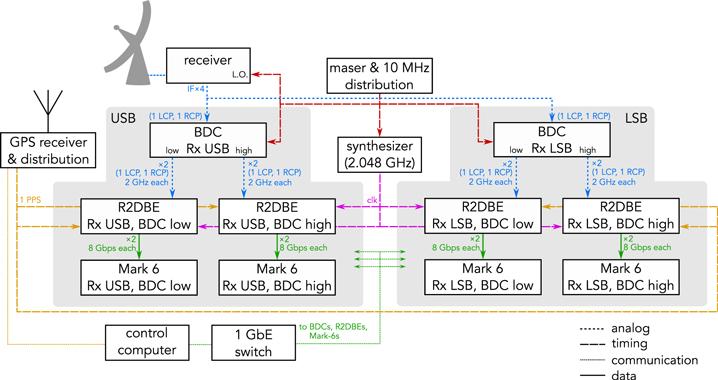

Немаловажный аспект работы VLBI – оцифровка больших объемов получаемых аналоговых данных. Для этой цели использовался компонент DBE (Digital Backend), основное требование к которому – достаточная скорость сэмплирования для соответствия пропускной способности комплекса EHT. Уже не в первом поколении этот компонент реализован на open-source технологиях, предоставляемых CASPER (Collaboration for Astronomy Signal Processing and Electronics Research). На текущий момент DBE-оборудование базируется на пяти 1Gsps (gigasample-per-second) конвертерах и платформе ROACH2 (Reconfigurable Open Access Computing Hardware).

Диаграмма одного из сайтов EHT (радиотелескоп и сопутствующие компоненты)

Для записи оцифрованных данных на жесткие диски использовалась система Marc 6, захватывающая два 8Gbps потока с DBE с помощью стандартных 10Gbps Ethernet сетевых адаптеров. Использование 4 таких рекордеров параллельно позволило получить суммарную производительность системы в необходимые 64Gpbs. Система обрабатывает полученные пакеты, убирая из них заголовки и записывая VDIF-фреймы. Для постоянной обработки 16Gbps-потоков данных, каждый рекордер Marc 6 разделяет данные и записывает их одновременно на 32 жестких диска по алгоритму round-robin. Жесткие диски разделены на группы по 8 и сгруппированы в 4 removable-модуля, позволяющих в любой момент отключить один из модулей для дальнейшей транспортировки.

Заключение

Как мы видим, проект Телескопа Горизонта Событий во многом основывается на кластеризации и виртуализации. Она коснулась и радиооптической части, и процедур анализа данных/построения изображений. Значительную роль в исследовании сыграли и облачные вычисления на базе суперкомпьютеров. Такое открытие вряд ли было бы возможным при использовании одиночных компонентов. Без виртуализации сети телескопов исследователям не удалось бы получить необходимое для столь сложного снимка разрешение, без использования облака на базе суперкомпьютеров анализ и калибровка полученных данных заняли бы годы, а без массивов на базе SSD-накопителей работа со столь существенным объемом данных была бы сильно затруднена.

Анализируя инфраструктуру, использовавшуюся для исследования, можно заметить и “узкое место” - пропускную способность сетей, которой оказалось недостаточно для трансграничной передачи полного объема полученных “сырых” данных, вследствие чего диски отправлялась авиаперевозкой.

В целом, данный проект - отражение процесса развития технологий работы с большими данными. Сложно себе представить, какие еще перспективы открывают такие технологии. Будем с нетерпением ждать роста средней пропускной способности сетей, дальнейшего развития технологий квантовых вычислений, машинного обучения и виртуализации, которые выведут работу с удаленной и виртуальной инфраструктурой на новый уровень как для провайдеров, таких как 1cloud.ru, так и для конечных пользователей.